Toute l'actualité de l'intelligence artificielle, du machine learning et du Big data dans le média Data Science Central

DSC Weekly 7 May 2024

Announcements Top Stories In-Depth

The post DSC Weekly 7 May 2024 appeared first...

Source: Data Science Central

Ten reasons organizations pay more in data integration...

Photo by Ernesto Andrade on Flickr Gartner's April 2024 IT forecast estimated...

Source: Data Science Central

The road to democratized AI with Kwaai

"Our goal is to redefine the interaction between technology and personal data. We...

Source: Data Science Central

GenAI, RAG, LLM… Oh My!

I am pleased to announce the release of my updated “Thinking Like a Data Scientist”...

Source: Data Science Central

7 Cool Technical GenAI & LLM Job Interview Questions...

This is not a repository of traditional questions that you can find everywhere on...

Source: Data Science Central

DSC Weekly 30 April 2024

Announcements Top Stories In-Depth

The post DSC Weekly 30 April 2024 appeared first...

Source: Data Science Central

How long does it take to master data engineering?

Data engineers are professionals who specialize in designing, implementing, and...

Source: Data Science Central

Cybersecurity practices and AI deployments

For our 4th episode of the AI Think Tank Podcast, we explored cybersecurity and...

Source: Data Science Central

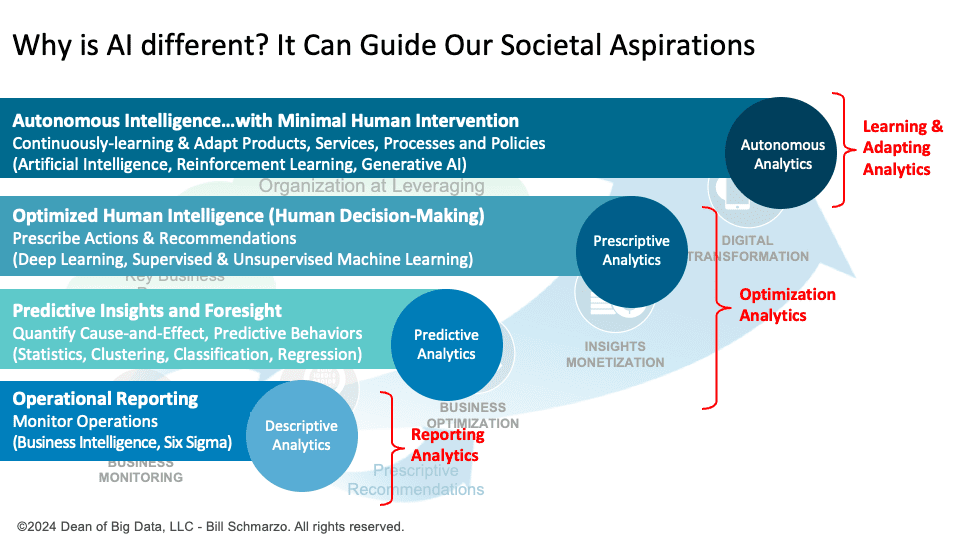

Why is AI different? It Can Guide Our Societal Aspirations...

Traditional analytics optimize based on existing data, reflecting past realities,...

Source: Data Science Central

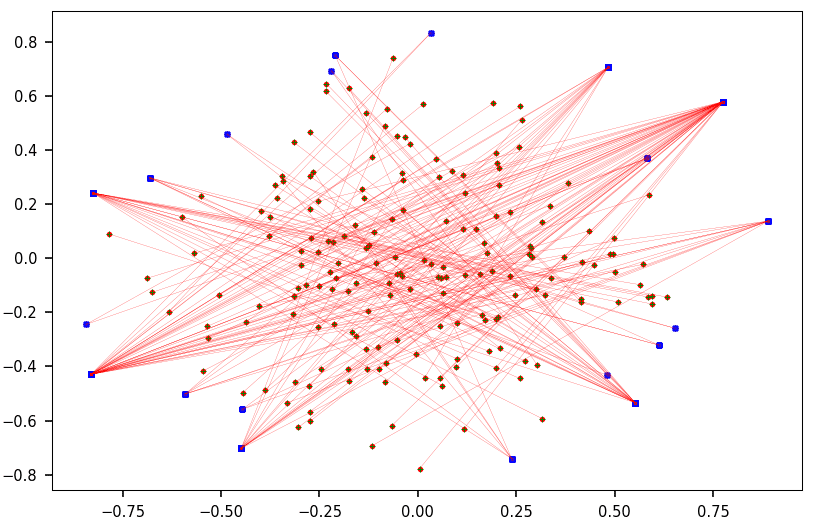

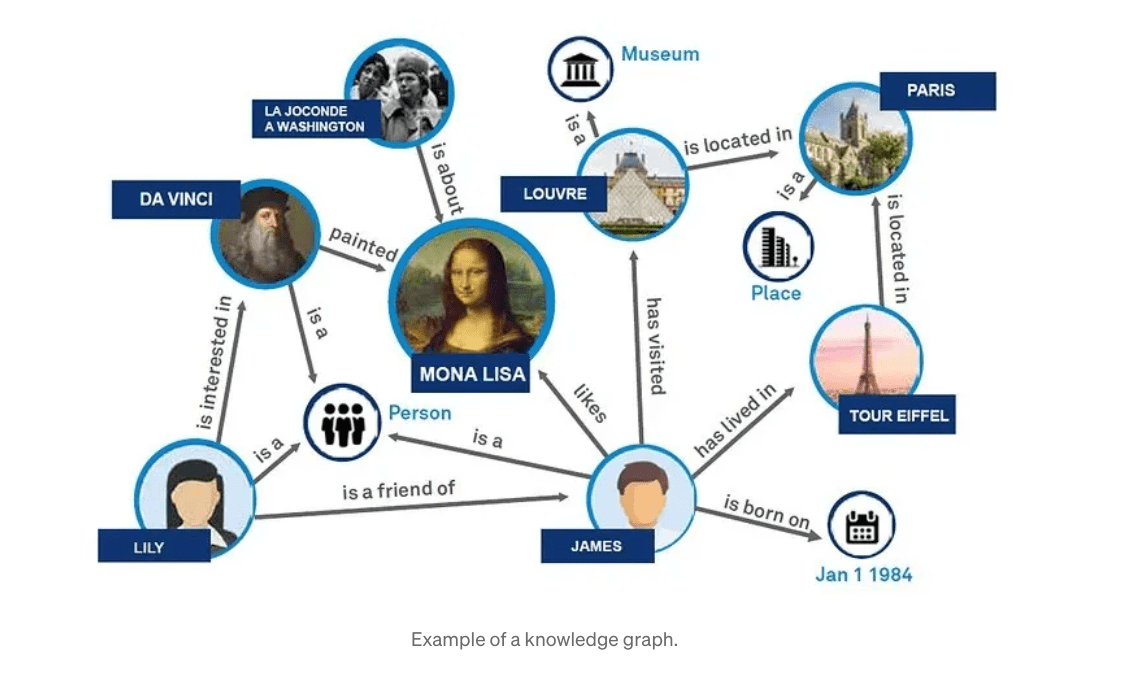

Understanding GraphRAG – 1: The challenges of RAG...

Background Retrieval Augmented Generation(RAG) is an approach for enhancing existing...

Source: Data Science Central

Top AI Influencers to Follow in 2024

There are many ways to define “top influencer”. You may just ask OpenAI...

Source: Data Science Central

DSC Weekly 23 April 2024

Announcements Top Stories In-Depth

The post DSC Weekly 23 April 2024 appeared first...

Source: Data Science Central

L'Intelligence Artificiel et le Big Data

Définitions

Intelligence Artificiel :

L'intelligence artificielle (IA) est un domaine de l'informatique qui vise à créer des systèmes et des machines capables de simuler l'intelligence humaine. L'objectif principal de l'IA est de développer des algorithmes et des modèles qui peuvent effectuer des tâches généralement associées à l'intelligence humaine, telles que la perception, le raisonnement, l'apprentissage, la planification, la prise de décision, la reconnaissance vocale, la compréhension du langage naturel, la résolution de problèmes, etc.

L'intelligence artificielle peut être divisée en deux catégories principales :

- L'intelligence artificielle faible (IA faible) : Également appelée intelligence artificielle étroite, elle se réfère à des systèmes qui sont conçus pour exécuter des tâches spécifiques et limitées. Ces systèmes ne démontrent pas une compréhension générale ou une conscience de soi. Ils sont généralement spécialisés dans une tâche particulière et ne peuvent pas facilement être transférés pour effectuer d'autres tâches.

- L'intelligence artificielle forte (IA forte) : Elle représente une forme d'intelligence artificielle qui est capable de fonctionner avec une compréhension similaire à celle d'un être humain. L'IA forte peut résoudre des problèmes complexes, apprendre de l'expérience, s'adapter à de nouvelles situations et accomplir des tâches variées sans avoir besoin d'être spécifiquement programmée pour chacune d'entre elles. Cependant, l'existence de l'IA forte est un sujet de débat et n'a pas encore été complètement réalisée.

L'une des approches les plus répandues pour mettre en œuvre l'intelligence artificielle est l'apprentissage automatique (machine learning) qui permet aux systèmes informatiques d'apprendre à partir de données, d'identifier des schémas et de prendre des décisions sans une programmation explicite. Les réseaux de neurones artificiels, en particulier les réseaux de neurones profonds (Deep Learning), sont devenus essentiels pour de nombreuses applications d'intelligence artificielle, comme la vision par ordinateur, la reconnaissance vocale et le traitement du langage naturel.

L'intelligence artificielle est utilisée dans une multitude de domaines, tels que la santé, la finance, la logistique, l'automobile, les jeux, la robotique et bien d'autres, offrant des avantages potentiels mais soulevant également des questions éthiques et sociales liées à l'automatisation, à la confidentialité des données, à la sécurité et à l'impact sur l'emploi.

Big Data :

Le "Big Data" (ou mégadonnées en français) est un terme utilisé pour décrire de vastes ensembles de données complexes, massives et souvent hétérogènes, qui dépassent la capacité des outils traditionnels de traitement et de gestion des données pour les analyser de manière efficace. Le Big Data se caractérise généralement par trois "V" :

- Volume : Le Big Data implique une énorme quantité de données, généralement de l'ordre des pétaoctets (10^15 octets) ou plus. Ces données peuvent être collectées à partir de diverses sources, telles que les réseaux sociaux, les appareils connectés à Internet, les capteurs, les appareils mobiles, les transactions commerciales, etc.

- Vitesse : Les données du Big Data sont souvent générées en temps réel ou à un rythme très rapide. Il est crucial de pouvoir traiter, analyser et prendre des décisions basées sur ces données à un rythme rapide pour en tirer un avantage concurrentiel.

- Variété : Les données du Big Data peuvent prendre différentes formes, y compris des données structurées (bases de données relationnelles), semi-structurées (JSON, XML) et non structurées (textes, images, vidéos). La variété des données rend leur traitement et leur analyse plus complexe.

En plus des trois V mentionnés ci-dessus, certains experts ajoutent également deux autres V :

- Vérité (Veracity) : Faire confiance à l'exactitude et à la qualité des données du Big Data peut être un défi. Les données peuvent être incomplètes, erronées ou provenir de sources peu fiables.

- Valeur (Value) : L'objectif ultime du Big Data est de transformer ces données en informations exploitables qui apportent une valeur ajoutée significative aux organisations ou aux individus.

Le Big Data joue un rôle essentiel dans de nombreux domaines, notamment le marketing, la santé, les sciences, la finance, la logistique, les sciences sociales, etc. En exploitant ces vastes quantités de données, les entreprises et les chercheurs peuvent découvrir des tendances, des schémas cachés, prendre des décisions plus éclairées, personnaliser les offres et améliorer l'efficacité opérationnelle. Pour gérer le Big Data, des technologies avancées telles que le calcul distribué, les systèmes de stockage massivement parallèles et les bases de données NoSQL sont utilisées pour faciliter le traitement et l'analyse des mégadonnées.